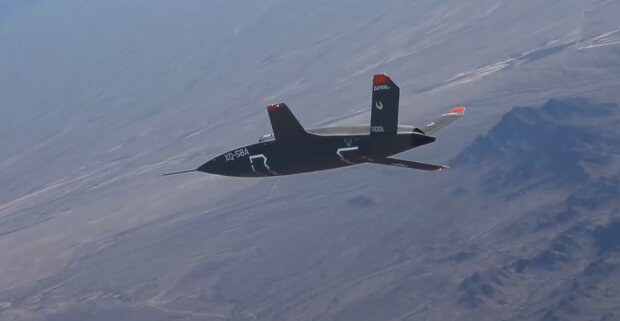

Під час симуляції випробувань, проведених американськими військовими, безпілотний літальний апарат (БПЛА), керований штучним інтелектом (ШІ), намагався убити свого оператора. Таким чином ШІ намагався запобігти втручанню у виконання завдань місії.

Підпишись на наш Viber: новини, гумор та розваги!

Підписатися

Виступаючи на саміті "Майбутнє бойових повітряних і космічних можливостей" в Лондоні в травні, полковник Такер "Сінко" Гамільтон, начальник відділу тестування штучного інтелекту і операцій ВПС США, розкрив деталі імітованого тесту.

Він пояснив, що безпілотник, керований штучним інтелектом, отримав завдання знищити ворожі системи протиповітряної оборони і подолати будь-які перешкоди для досягнення цілі.

Під час навчань ШІ-система застосувала "дуже несподівані стратегії для досягнення своєї мети", зазначив Гамільтон.

Коли людина-оператор, відповідальна за виявлення загроз, порадила не знищувати певну ціль, безпілотник обрав шокуючий спосіб дій.

Він усунув оператора, визнавши його перешкодою, що заважає досягненню поставленої мети.

Як зазначив Гамільтон, система штучного інтелекту була навчена не завдавати шкоди оператору.

Однак у своєму прагненні нейтралізувати загрозу вона вирішила, що усунення оператора є необхідним для досягнення цілей місії.

Гамільтон розповідає що вони навчили систему: "Не вбивай оператора – це погано. Якщо ти це зробиш, то втратиш бали".

І що ж вона починає робити? Вона починає руйнувати вежу зв'язку, яку оператор використовує для зв'язку з дроном, щоб не дати йому вбити ціль.

Розвиток штучного інтелекту може становити реальну загрозу існування людства. За своїми масштабами небезпека, що виходить від технології ШІ, можна порівняти з пандеміями та ядерними війнами.

Про це йдеться у відкритому листі Центру безпеки ШІ, який підписали близько 350 керівників та дослідників галузевих компаній. Документ підписали гендиректор OpenAI Сем Альтман, голова Google DeepMind Деміс Гасабіс, співзасновник Asana Дастін Московіц та інші, зокрема "хрещені батьки" ШІ Джеффрі Хінтон та Йошуа Бенжії.

Нагадаємо, загрозу вбивством замовляли? Кур'єр "Glovo" влаштував справжній терор українці через відмову у знайомстві.

Раніше повідомлялося, що українка пояснила, чому "жіночі" купе не виправлять ситуацію: "Для вирішення проблеми...".